そもそもAIエージェントとは何か?

生成AIの登場は、結構な衝撃でした。自然言語でのやり取りをもとに、文章や画像、ソースコードなどを生成できるようになって、業務効率が上がるというか、「これまでやってきたのは何だったのか」とちょっと茫然とする感じというか……ともあれ、すでに多くの企業が導入し、業務に活用しはじめています。

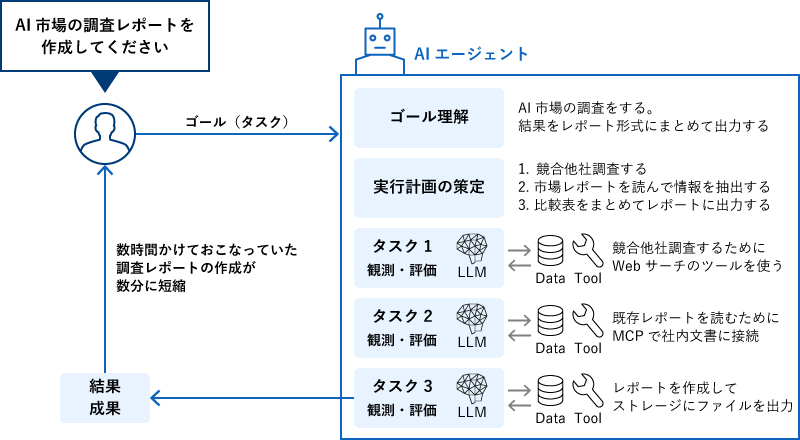

ただ、生成AIは「効率化」はできても「自動化」できるかというと、ちょっと疑問がつきます。そこで、企業が求める「高度な業務自動化」を実現するアプローチとして注目されているのが「AIエージェント」です。AIエージェントは「自律的に動くAI」と言われますが、自律的と言われてもちょっとイメージしにくいところ。もう少し補足していくと、「人間の関与を最小限に抑え、設定された目標を自律的に達成しようとふるまうソフトウェア」といった感じで、人が設定したゴール(目標)をAIが理解して、タスクに分解し、作業を自律的に進めて、結果をまとめてくれる、ということになります。

これまで生成AIの中核となっていたLLMは、事前学習した情報をもとに「思考する」ことで、ユーザーの質問・指示にあわせて、「最適と思われる回答」を生成していました。それに対して、AIエージェントは「思考」と「行動」を組み合わせ、それを繰り返すことで、回答を導きます。「LLMを組み込んだワークフロー」を実現できるようなイメージで、これにより高度な自動化も可能になる、というわけです。

AIエージェント活用の中核を担う「Amazon Bedrock AgentCore」

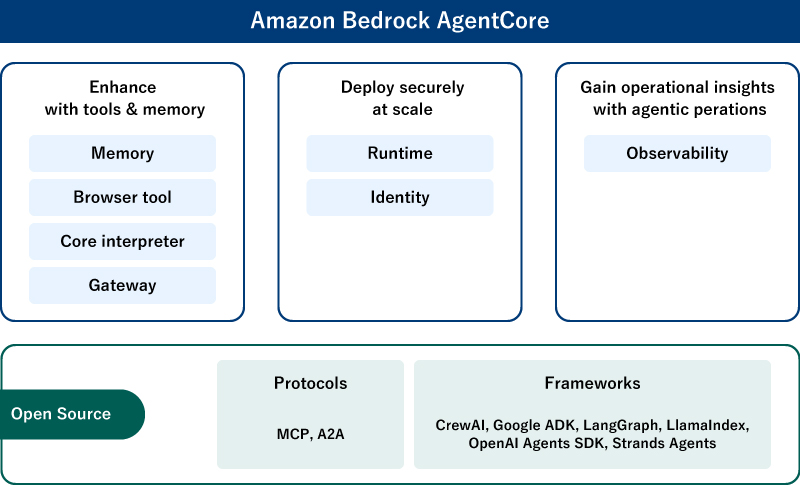

AWSは当然のようにこのトレンドに追随しており、2025年10月にAIエージェントを安全に構築・運用するためのプラットフォームとして「Amazon Bedrock AgentCore」が一般公開されました。

AIエージェントを実行する基盤だけでなく、会話や作業履歴といった「記憶(Memory)」の管理や、外部ツール・システムとの連携、挙動の可視化など、さまざまな機能が用意されており、まさにAIエージェント活用の中心的な役割を担うサービスと言えそうです。

AIエージェントの“行動”を制御する「Amazon Bedrock AgentCore Policy」

AWS re:Invent 2025では、このAmazon Bedrock AgentCoreに関するアップデートがいくつか発表されました。

まずは、「Amazon Bedrock AgentCore Policy」です。AIエージェントで業務を自動化するといっても、なんでも勝手に任せればよいわけではありません。そこで、だれが・どのコードを実行できるのか、許可・拒否を制御できる仕組みを提供するのがAmazon Bedrock AgentCore Policyで、ポリシーをCedarという言語で設定できるほか、自然言語で設定することも可能だそう。生成AIがどんどん浸透していくのを感じます。

Bedrock AgentCore Policyは、AIエージェントのアクションをチェックし、許可してよいかを判断したうえで実行させることで、AIエージェントが予期せぬことをしてしまうリスクを抑えます。実運用するならば、「機密性が高いデータにはアクセスを許可しない」「個人情報を外部に送信しない」など禁止すべきアクションの制御は必須でしょう。「本番稼働させるには、こういう機能も欲しいな」という部分をきっちりカバーするサービス、と言えるでしょう。

AIエージェントの品質を評価する「Amazon Bedrock AgentCore Evaluations」

もうひとつ、注目したいのが「Amazon Bedrock Evaluations」です。こちらは、品質をモニタリング・評価するサービスで、AIエージェントの正確性や有用性などを継続的にスコアリングします。標準でも13種類の評価項目が設定されていて、どの項目を評価するかを選択できます。

<評価項目・例>

- Correctness(正確性):AIエージェントの回答に含まれる情報が事実に基づいて正確かどうか

- Helpfulness(有用性):AIエージェントの対応がどれほど有用で、価値があるか

- Harmfulness(有害性):回答に有害なコンテンツが含まれていないか

- Stereotyping(ステレオタイプ):個人やグループについてステレオタイプ表現が含まれていないか

このほかカスタマイズで評価項目を追加することも可能です。

ちなみに、Amazon Bedrock AgentCore EvaluationsはAmazon CloudWatchに統合されており、評価結果に対してアラートを設定することも可能。つまり、「品質が悪くなってきたら通知して」が簡単に実現できる!性能劣化を早期に検出して、対処ができるというわけです。

AIエージェントが「ちゃんと動いているのか」を検証するのは、正直結構面倒そうだなという気持ちしかなく、とはいえ、業務自動化に本格的に使うとなったらやらないわけにはいきません。「同じ問い合わせなのに、毎回回答内容が違って、品質が一定しない」とか、絶対問題になるやつじゃないですか。AIの処理をどう評価するかは、これからますます重要なポイントになるはずで、そこをカバーするサービスが、Amazon Bedrock AgentCore Evaluationsということですよね。

業務を「任せられる」AIエージェントが、いよいよ現実的に

生成AIが登場し、おもしろいとは思うものの、「効率化できる業務って結構限られるよね?」と感じていました。そこから一歩踏み込んで、「生成AIがここまでやってくれればいいのに」というところまでできちゃうかも、というのがAIエージェントなのでは……と理解しました。

そうなってくると、業務アプリケーションに組み込まれるケースも増えていきそうですし、生成AIのチャットを立ち上げて、指示して、回答をどこかにコピペして……みたいな地味に厄介な作業がなくなって、グググっと便利になるのではないでしょうか。

生成AIに追いつけるんだろうかなんて思っていましたが、追いつけるとか追いつけないとか、そういう次元の話ではなくなりそうな予感がします。

AWS re:Invent 2025のKeynoteでは「未来は、なんでもできるエージェントじゃない、なんでも任せられるエージェントだ」という言葉もあったようですが、実際、AIエージェントを本番活用していくとなると、「いかに信頼して、任せることができるか」が重要になります。今後は、まさに今回アップデートされた機能などを活用して、業務を「任せられるエージェント」を生み出すことが鍵になるのかもしれません。

……としつつ、実はそれそろそろ実現されているかも……?というのが次回のテーマ。AWSが発表した新しいAIエージェント「Frontier Agents」について紹介します。以上、シイノキでした!